过拟合与欠拟合 专业名词解释: 泛化误差(generalization error):指模型在任意一个测试数据样本上表现出来的误差的期望,我们通常用测试集上的误差来近似看待. 验证集(validation set):预留一部分训练数据集...

”rnn 数据拟合 梯度 梯度下降 欠拟合 正则化 过拟合“ 的搜索结果

一.过拟合 在训练数据不够多时,或者over-...可是在验证集上的error却反而渐渐增大——由于训练出来的网络过拟合了训练集,对训练集以外的数据却不work。 在机器学习算法中,我们经常将原始数据集分为三部分:训练...

过拟合、梯度消失、RNN进阶

标签: 深度学习

一、过拟合和欠拟合 训练误差:指模型在训练数据集上表现出的误差。 泛化误差:指模型在任意一个测试数据样本上表现出的误差的期望,并常常通过测试数据集上的误差来近似。(ML应关注此项) 如何计算训练误差或者...

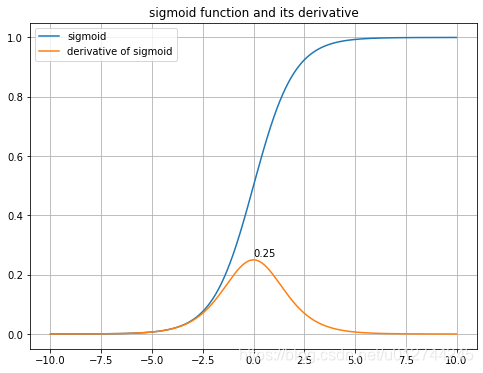

目前,优化神经网络参数的方法都是基于反向传播的思想,即根据损失函数计算的误差通过梯度反向传播的方式,指导深度网络权值的更新优化。整个深度网络可以视为是一个复合的非线性多元函数 : 栗子: 表达式为:...

深度学习网络模型

正则化(过拟合),卷积神经网络(CNN,卷积运算基础,参数学习,感受野,稀疏交互,权值共享,平移不变性,池化,转置卷积,空洞卷积),循环神经网络(RNN,记忆能力,双向循环神经网络,长程依赖问题,长短期记忆...

RNN(Recurrent Neural Network)是一类用于处理序列数据的神经网络。 RNN存在一些问题梯度较容易出现衰减或爆炸(BPTT) - 梯度爆炸,梯度消失 首先举一个例子: 如果有一个层输为LLL的多层感知机的第lll层H(l)\...

2. 正则化(Regularization):通过正则化可以对模型进行约束,防止过拟合。常用的正则化方式包括L1正则化和L2正则化。L1正则化通过加入L1范数的惩罚项,使得模型的参数稀疏化;L2正则化通过加入L2范数的惩罚项,...

训练集数据太少,会引起过拟合,模型越越简单,会引起欠拟合。折中办法是在保证能够训练的情况下,模型尽量复杂,数据量也随之增多 机器学习中遇到的方法: 正则化:在loss函数中加入,w^2项来强行训练减少loss,...

摘要: Dropout正则化是最简单的神经网络正则化方法。阅读完本文,你就学会了在Keras框架中,如何将深度学习神经网络Dropout正则化添加到深度学习神经网络模型里。Dropout正则化是最简单的神经网络正则化方法。其...

由于模型过于复杂,学习能力过强,而用于训练的数据相对于复杂模型来说比较简单,所有模型会去学习数据中隐含的噪声,导致模型学不到真正数据集的分布,如下图所示,红色线就是由于模型过分的拟合了训练数据集,导

1.51.RNN训练难题–梯度弥散与梯度爆炸 1.51.1.梯度弥散与梯度爆炸 1.51.2.详解机器学习中的梯度消失、爆炸原因及其解决方法 1.51.2.1.前言 1.51.2.2.第一部分:为什么要使用梯度更新规则 1.51.2.3.第二部分:梯度...

Task03-(过拟合、欠拟合,梯度消失、爆炸,循环神经网络进阶) 过拟合欠拟合及其解决方案 训练误差:指模型在训练数据集上表现出的误差。 泛化误差:指模型在任意一个测试数据样本上表现出的误差的期望,并常常通过...

批量归一化(Batch Normalization)是一种对神经网络中间层的输出进行标准化的方法,能够帮助解决模型的快速收敛、加速训练、防止过拟合等问题。在深度学习领域,卷积神经网络(CNN)或循环神经网络(RNN)往往带来...

一过拟合、欠拟合及其解决方案 1.1 欠拟合与过拟合 1.2 过拟合解决方案 1.3 欠拟合解决方案 二 梯度消失、梯度爆炸 2.1 梯度消失 2.2 梯度爆炸 三 循环神经网络进阶 3.1 循环神经网络的主要结构 3.2 ...

1 过拟合、欠拟合及其解决方案 训练误差和泛化误差 在解释上述现象之前,我们需要区分训练误差(training error)和泛化误差(generalization error)。通俗来讲,前者指模型在训练数据集上表现出的误差,后者指模型...

RNN的正规化方法对dropout的扩展层归一化参考文献 神经翻译笔记4扩展b. RNN的正规化方法 本系列笔记前文介绍了若干神经网络常用的泛化方法,本文将延续这一话题,介绍若干适用于RNN的泛化/正规化方法 对dropout的...

CNN 1 卷积神经网络与传统多层神经网络对比 传统意义上的多层神经网络是只有输入层、隐藏层、输出层。 卷积神经网络CNN,在原来多层神经网络的基础上,加入了更加有效的特征学习部分,具体操作就是在原来的全连接...

过拟合、欠拟合及其解决方案 训练误差和泛化误差 过拟合和欠拟合的概念 模型复杂度和误差之间的关系 解决过拟合的方案 梯度消失及梯度爆炸 循环神经网络进阶 GRU LSTM 深度神经网络 过拟合、欠拟合及其...

文章目录深度学习基础3一、过拟合欠拟合1.概念2.解决过拟合欠拟合的方法(1)权重缩减 一、过拟合欠拟合 1.概念 欠拟合:训练误差(训练集的损失函数的值)较大。 过拟合:训练误差远远小于泛化误差(任意...

深度学习中的正则化与防过拟合策略

标签: 人工智能

在深度学习中,正则化是一种用来减少模型过拟合的技术。过拟合是指模型在训练集上表现很好,但在测试集上表现较差的情况,通常是因为模型过于复杂,拟合了训练数据中的噪声。正则化通过在模型的损失函数中添加惩罚项...

Task3过拟合、欠拟合及其解决方案训练误差、泛化误差模型选择验证数据集K折交叉验证过拟合欠拟合概念模型复杂度 过拟合、欠拟合及其解决方案 训练误差、泛化误差 前者指模型在训练数据集上表现出的误差。 后者指模型...

梯度消失、梯度爆炸)一、过拟合、欠拟合及其解决方案1、引入(1)训练误差与泛化误差(2)过拟合与欠拟合2、模型复杂度3、训练数据集大小4、过拟合解决方法1——权重衰减(等价与L2 范数正则化)4、过拟合解决方法2...

一、过拟合、欠拟合及其解决方案 过拟合:模型在训练集上取得的效果较好,误差较低,但是在训练集上出现较大误差 欠拟合:建立的模型在训练集和测试集上均出现较高的误差。 解决方案 1.模型复杂度 假设我们要预测的...

推荐文章

- 大数据和云计算哪个更简单,易学,前景比较好?_大数据和云计算哪个好-程序员宅基地

- python操作剪贴板错误提示:pywintypes.error: (1418, 'GetClipboardData',线程没有打开的剪贴板)...-程序员宅基地

- IOS知识点大集合_ios /xmlib.framework/headers/xmmanager.h:66:32: ex-程序员宅基地

- Android Studio —— 界面切换_android studio 左右滑动切换页面-程序员宅基地

- 数据结构(3):java使用数组模拟堆栈-程序员宅基地

- Understand_6.5.1175::New Project Wizard_understand 6.5.1176-程序员宅基地

- 从零开始带你成为MySQL实战优化高手学习笔记(二) Innodb中Buffer Pool的相关知识_mysql_global_status_innodb_buffer_pool_reads-程序员宅基地

- 美化上传文件框(上传图片框)_文件上传框很丑-程序员宅基地

- js简单表格操作_"var str = '<table border=\"5px\"><tr><td>序号</td><-程序员宅基地

- Power BI销售数据分析_powerbi汇总销售人员业绩包括无销售记录的人-程序员宅基地